Spark の Python 実行環境である PySpark を Jupyter Notebook で起動する方法です。PySpark 単体だと補完も効かずに使いにくいですが、Jupyter Notebook と組み合わせる事で使い勝手が格段に向上します。

Jupyter NotebookとSparkの用意

初めに以下の記事を参考にして Jupyter Notebook を起動できるようにしましょう。ローカルの Mac でもサーバー上でもどちらでもいいです。

Jupyter Notebook(IPython)のインストールと始め方 - TASK NOTES

Jupyter Notebook(IPython)サーバの起動方法 - TASK NOTES

Jupyter Notebook が起動できたら Spark をインストールします。

Spark の起動設定

PySpark を Jupyter Notebook で使用したいので、Spark の設定ファイルspark-env.shを変更します。Mac で試していますが CentOS でも同じです。

$ cd /usr/local/Cellar/apache-spark/1.6.0/libexec/ $ cp conf/spark-env.sh.template conf/spark-env.sh $ vi conf/spark-env.sh

ファイルの一番下に PySpark を起動するドライバやオプションの環境変数を設定してください。例では pyenv を使用していますが、環境に合わせて適宜読み替えてください。

export PYSPARK_PYTHON=$PYENV_ROOT/shims/python export PYSPARK_DRIVER_PYTHON=$PYENV_ROOT/shims/jupyter export PYSPARK_DRIVER_PYTHON_OPTS="notebook"

設定できたらpysparkコマンドを実行してみましょう。Jupyter Notebook が起動されます。

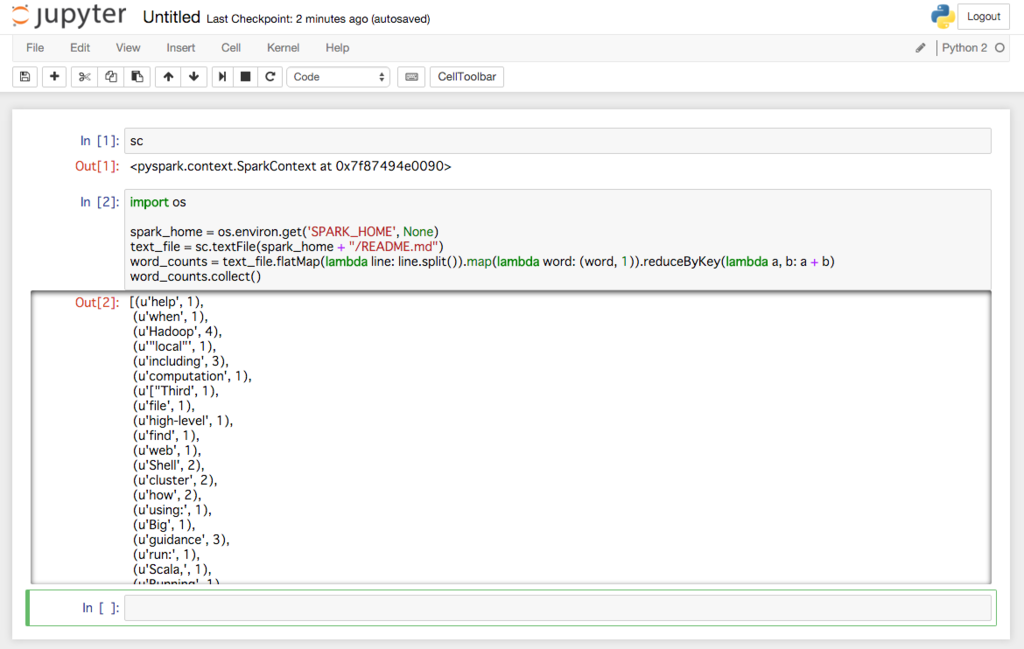

scだけ入力して実行すると、成功していれば SparkContext のインスタンスが表示されるはずです。ついでに WordCount を実行してみました。